мХИлЕХнХШмДЄмЪФ. Playce CloudнМА мЭімД±л¶ЉмЮЕлЛИлЛ§.

мњ†л≤ДлД§нЛ∞мК§ нММлУЬ лД§нКЄмЫМнБђмЧР мЭімЭА лСР л≤ИмІЄ мєЉл¶ђмљФмЮЕлЛИлЛ§.

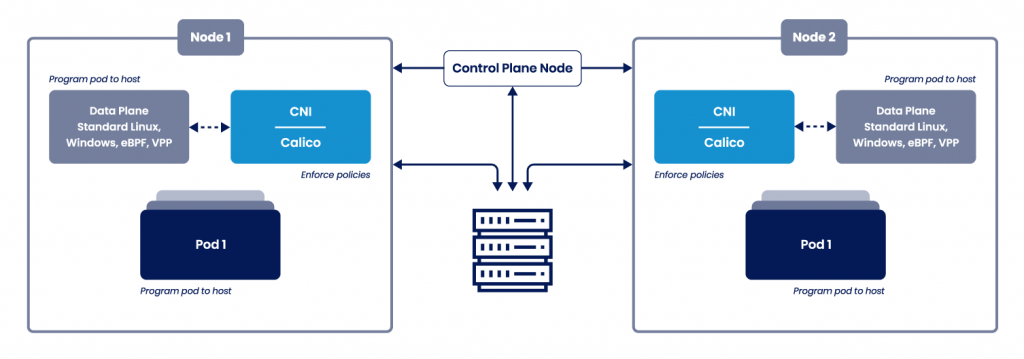

мњ†л≤ДлД§нЛ∞мК§ лД§нКЄмЫМнБђлКФ CNI(Container Network Interface) нСЬм§АмЭД мІАнВ§лКФ лД§нКЄмЫМнБђ нФМлЯђкЈЄмЭЄмЭі нХДмЪФнХ©лЛИлЛ§. CNI нСЬм§АмЭД мІАнВ§лКФ мЖФл£®мЕШмЭА Calico мЭімЩЄмЧРлПД лЛ§мЦСнХЬ мД†нГЭмІАк∞А мЮИмІАлІМ м†АнЭђ нМАмЧРмДЬ мД§к≥Д/м†ЬмХИ нХ† лХМ м£Љл°Ь мД†нГЭнХШлКФ к≤ГмЭі CalicoмЭікЄ∞ лХМлђЄмЧР м£Љм†Ьл°Ь мД†м†ХнХШмШАмКµлЛИлЛ§. лД§нКЄмЫМнБђ нФМлЯђкЈЄмЭЄмЧРмДЬ мІАмЫРнХШлКФ нХ≠л™©мЭілВШ нКємД±, мД±лК•мЧР лФ∞лЭЉмДЬ лЛ§л•Є нФМлЯђкЈЄмЭЄмЭД мД†нГЭнХШмЧђ мВђмЪ©нХ† мИШ мЮИмКµлЛИлЛ§.

CNI м∞Єк≥† мВђмЭінКЄ)

https://kubernetes.io/ko/docs/concepts/extend-kubernetes/compute-storage-net/network-plugins/

https://github.com/containernetworking/cni

мњ†л≤ДлД§нЛ∞мК§ лД§нКЄмЫМнБђ нФМлЯђкЈЄмЭЄмЭА нСЬм§А CNIл•Љ лФ∞лЭЉмХЉ нХЬлЛ§к≥† нХШлКФлН∞ мХДлЮШмЩА к∞ЩмЭА мЪФкµђмВђнХ≠мЭі мЮИлЛ§к≥† нХ©лЛИлЛ§. мњ†л≤ДлД§нЛ∞мК§л•Љ к≤љнЧШнХі л≥імЛ† лґДмЭілЭЉл©і лЛємЧ∞нЮИ лРШмЦімХЉ нХ† кЄ∞лК•мЬЉл°Ь мГЭк∞БлРШмІА мХКмЬЉмЛ†к∞АмЪФ?

1. veth нОШмЦі мГЭмД± л∞П мї®нЕМмЭілДИ лД§нКЄмЫМнБђ мЭЄнД∞нОШмЭімК§мЩА мЧ∞к≤∞

2. Pod лД§нКЄмЫМнБђ лМАмЧ≠ нЩХмЭЄ нЫД IP мД§м†Х

3. CNI мД§м†Х нММмЭЉ мЮСмД±

4. IP мД§м†Х л∞П кіАл¶ђ

5. мї®нЕМмЭілДИ лВі кЄ∞л≥Є лЭЉмЪ∞нМЕ м†Хл≥і мВљмЮЕ (default route rule)

6. лПЩл£М лЕЄлУЬлУ§мЧРк≤М IP лЭЉмЪ∞нМЕ м†Хл≥і м†ДлЛђ(advertising the routes)

7. нШЄмК§нКЄ мДЬл≤ДмЧР лЭЉмЪ∞нМЕ м†Хл≥і мВљмЮЕ

8. лД§нКЄмЫМнБђ м†Хм±ЕмЧР лФ∞лЭЉ нКЄлЮШнФљ м≤Шл¶ђ

...

мґЬм≤Ш - https://coffeewhale.com/packet-network2

мєЉл¶ђмљФ к∞Ьл∞Ь нЪМмВђмЭЄ Tigera нЩИнОШмЭімІАмЧРмДЬ мєЉл¶ђмљФ мХДнВ§нЕНм≤Шл•Љ нЩХмЭЄнХ† мИШ мЮИмКµлЛИлЛ§.

лД§нКЄмЫМнБђ нФМлЯђкЈЄмЭЄмЭА лЕЄлУЬ/нММлУЬ нЖµмЛ†мЭД мЫРнХ†нХШк≤М нХім£ЉлКФ мЧ≠нХ†мЭД нХШкЄ∞ лХМлђЄмЧР мњ†л≤ДлД§нЛ∞мК§ лЕЄлУЬмЧР лД§нКЄмЫМнБђ нЩФмВінСЬлІМ ꣪놧솪 мЮИлКФ к≤ГмЭД л≥Љ мИШ мЮИмКµлЛИлЛ§. к∞ДлЛ®нХЬ кЈЄл¶ЉмЭі мЛ§м†Ьл°ЬлКФ мЦілЦїк≤М кµђмД±мЭі лРШмЦім†Є мЮИлКФмІА нЩХмЭЄнХіл≥ілПДл°Э нХШк≤†мКµлЛИлЛ§.

мД§л™ЕмЧР мД§л™ЕнХШлКФ мњ†л≤ДлД§нЛ∞мК§мЧРмДЬ мВђмЪ©нХШлКФ мєЉл¶ђмљФ л≤Дм†ДмЭА v3.21.2мЮЕлЛИлЛ§.

root@sung-ubuntu01:~/tmp# calicoctl version

Client Version: v3.21.2

Git commit: 17461419

Cluster Version: v3.21.2

Cluster Type: kubespray,bgp,kubeadm,kdd,k8scalicoctl л™Ел†ємЦіл°Ь л™®лУ† лЕЄлУЬк∞А л©ФмЙђ нШХнГЬл°Ь мЧ∞к≤∞лРШмЦі мЮИлКФ к≤ГмЭД нЩХмЭЄ нХ† мИШ мЮИмКµлЛИлЛ§.

root@sung-ubuntu01:~/tmp# calicoctl node status

Calico process is running.

IPv4 BGP status

+-----------------+-------------------+-------+----------+-------------+

| PEER ADDRESS | PEER TYPE | STATE | SINCE | INFO |

+-----------------+-------------------+-------+----------+-------------+

| 192.168.110.101 | node-to-node mesh | up | 02:45:04 | Established |

| 192.168.110.103 | node-to-node mesh | up | 02:40:50 | Established |

| 192.168.110.104 | node-to-node mesh | up | 02:41:00 | Established |

| 192.168.110.102 | node-to-node mesh | up | 02:44:42 | Established |

+-----------------+-------------------+-------+----------+-------------+

root@sung-ubuntu04:~# calicoctl node status

Calico process is running.

IPv4 BGP status

+-----------------+-------------------+-------+----------+-------------+

| PEER ADDRESS | PEER TYPE | STATE | SINCE | INFO |

+-----------------+-------------------+-------+----------+-------------+

| 192.168.110.100 | node-to-node mesh | up | 02:40:49 | Established |

| 192.168.110.101 | node-to-node mesh | up | 02:45:02 | Established |

| 192.168.110.104 | node-to-node mesh | up | 02:40:59 | Established |

| 192.168.110.102 | node-to-node mesh | up | 02:44:42 | Established |

+-----------------+-------------------+-------+----------+-------------+

лІИмК§нД∞ лЕЄлУЬмЧРмДЬ wokrloadEndpointл•Љ м°∞нЪМнХШл©і, мГЭмД±лРЬ нММлУЬ м†Хл≥імЩА лЕЄлУЬ мЬДмєШ, мЭЄнД∞нОШмЭімК§кєМмІА нЩХмЭЄ нХ† мИШ мЮИмКµлЛИлЛ§.

*master мДЬл≤ДмЧРмДЬлІМ мґЬ놕

# мГЭмД±лРЬ нММлУЬмЧР лМАнХЬ мЬДмєШ, м†Хл≥і нЩХмЭЄ

root@sung-ubuntu01:~/tmp# calicoctl get workloadEndpoint

WORKLOAD NODE NETWORKS INTERFACE

multi-container sung-ubuntu05 10.233.78.3/32 calib4cfe5eb958

multi-container2 sung-ubuntu04 10.233.99.2/32 calia85a668c715

ubuntu-test sung-ubuntu04 10.233.99.1/32 calie3df4d89b13

BGP нФЉмЦілІБмЭА 179л≤И нПђнКЄл•Љ мВђмЪ©нХШл©∞, мХДлЮШ BGP кЈЄл¶ЉмЭД м∞Єк≥†нХШмЛЬл©і мЭінХінХШкЄ∞к∞А мЙљмКµлЛИлЛ§.

root@k8s-master01:~# netstat -antlp | grep 179

tcp 0 0 0.0.0.0:179 0.0.0.0:* LISTEN 831313/bird

tcp 0 0 192.168.110.111:179 192.168.110.115:54063 ESTABLISHED 831313/bird

tcp 0 0 192.168.110.111:179 192.168.110.112:40507 ESTABLISHED 831313/bird

tcp 0 0 192.168.110.111:179 192.168.110.113:52189 ESTABLISHED 831313/bird

tcp 0 0 192.168.110.111:179 192.168.110.114:51323 ESTABLISHED 831313/bird

Q. мЬД мГБнГЬмЧРмДЬ multi-container2 нММлУЬл•Љ мВ≠м†ЬнХШл©і sung-ubuntu04 лЕЄлУЬмЭШ мЭЄнД∞нОШмЭімК§лКФ мЦілЦїк≤М л≥АнХ†кєМмЪФ?

-> мєЉл¶ђмљФ workloadEndpointмЧРмДЬлПД мВ≠м†Ь лРШк≤†мІАлІМ лЕЄлУЬмЧРмДЬ мГЭмД±лРЬ нХілЛє нММлУЬмЩА мЧ∞к≤∞лРЬ мЭЄнД∞нОШмЭімК§лПД мВ≠м†Ь лР©лЛИлЛ§. ifconfig л™Ел†ємЦіл°Ь нЩХмЭЄ мЛЬ calib4cfe5eb958 мЭЄнД∞нОШмЭімК§к∞А мВ≠м†ЬлРШк≤М лР©лЛИлЛ§.

BGP(Border Gateway Protocol)

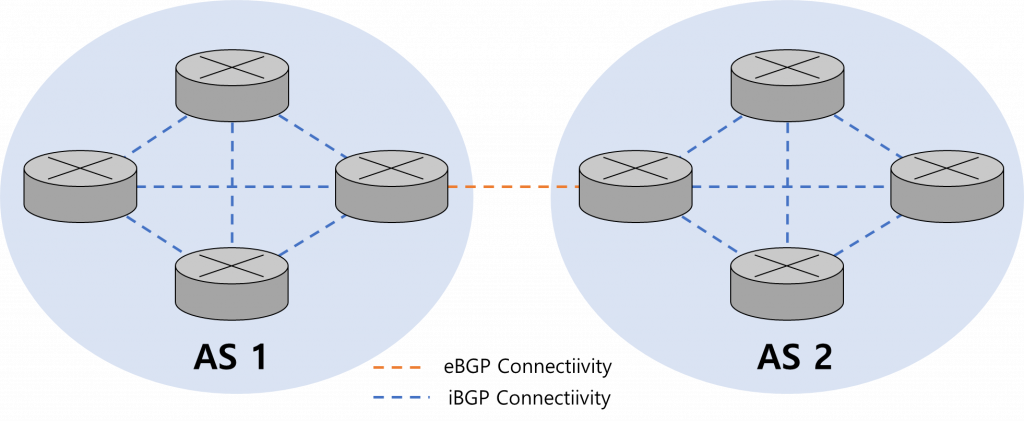

BGPлКФ кЄ∞мЧЕмЭШ мВђлВілІЭк≥Љ мЭЄнД∞лДЈ, кµ≠к∞А к∞Д нЖµмЛ† л∞©л≤ХмЧР лєДмЬ† нХ† мИШ мЮИмКµлЛИлЛ§. AS(Autonomous System)мЭА к∞Б ZoneмЭД мЭШлѓЄнХШл©∞, мњ†л≤ДлД§нЛ∞мК§мЧРмДЬлКФ нХілЛє лВімЪ©мЭД к∞Б лЕЄлУЬ лВі нММлУЬ нЖµмЛ†к≥Љ лЕЄлУЬ к∞ДмЭШ нЖµмЛ†мЬЉл°Ь м†БмЪ©нХШмЧђ мД§л™Е нХ† мИШ мЮИмКµлЛИлЛ§.

AS к∞Д нЖµмЛ†мЭА eBGPлЭЉк≥† нХШл©∞, AS лВі нЖµмЛ†мЭА iBGPлЭЉк≥† нХ©лЛИлЛ§.

рЯТ° л¶ђлИЕмК§ лД§мЮДмК§нОШмЭімК§

1. л¶ђлИЕмК§ мЛЬмК§нЕЬмЭА міИкЄ∞ кµђлПЩ мЛЬ нХШлВШмЭШ лЛ®мЭЉ лД§мЮДмК§нОШмЭімК§л•Љ к∞ЦлКФлЛ§.

2. нММмЭЉ мЛЬмК§нЕЬ, нФДл°ЬмДЄмК§ID, мВђмЪ©мЮРID, лД§нКЄмЫМнБђ мЭЄнД∞нОШмЭімК§ лУ±к≥Љ к∞ЩмЭА л™®лУ† мЛЬмК§нЕЬ мЮРмЫРмЭА лЛ®мЭЉ лД§мЮДмК§нОШмЭімК§мЧР мЖНнХЬлЛ§.

3. лД§мЮДмК§нОШмЭімК§л•Љ мґФк∞Ал°Ь лІМлУ§к≥† л¶ђмЖМмК§л•Љ кµђмД±нХ† мИШ мЮИлЛ§.

4. нФДл°ЬмДЄмК§л•Љ мЛ§нЦЙнХШл©і нФДл°ЬмДЄмК§лКФ лД§мЮДмК§нОШмЭімК§ м§С нХШлВШмЧРмДЬлІМ мЛ§нЦЙлРШл©∞ лПЩмЭЉ лД§мЮДмК§нОШмЭімК§ лВі л¶ђмЖМмК§лІМ л≥ЉмИШ мЮИлЛ§.

5. мЧђлЯђ мҐЕл•ШмЭШ лД§мЮДмК§нОШмЭімК§к∞А м°імЮђнХШлѓАл°Ь нФДл°ЬмДЄмК§лКФ нХШлВШмЭШ лД§мЮДмК§нОШмЭімК§мЧРлІМ мЖНнХШмІА мХКк≥† к∞Б мҐЕл•ШмЭШ лД§мЮДмК§нОШмЭімК§мЧР мЖНнХЬлЛ§.

6. лД§мЮДмК§нОШмЭімК§лКФ лІИмЪінКЄ(mnt), нФДл°ЬмДЄмК§(pid), лД§нКЄмЫМнБђ(net), нФДл°ЬмДЄмК§к∞Д нЖµмЛ†(ipc), UTS, мВђмЪ©мЮРID(user)к∞А мЮИлЛ§.

Q. мї®нЕМмЭілДИк∞А л¶ђлИЕмК§мЭШ лД§мЮДмК§нОШмЭімК§ к≤©л¶ђ кЄ∞мИ†мЭД нЩЬмЪ© нХЬлЛ§лНШлН∞.. мЦілЦїк≤М нЩХмЭЄнХ† мИШ мЮИмЭДкєМмЪФ?

#лД§нКЄмЫМнБђ лД§мЮДмК§нОШмЭімК§ нЩХмЭЄ

root@sung-ubuntu04:~# lsns -t net

NS TYPE NPROCS PID USER NETNSID NSFS COMMAND

4026531992 net 160 1 root unassigned /run/docker/netns/default /sbin/init

4026532314 net 3 313510 root 0 /run/docker/netns/6c1ef9da93ed /pause

4026532393 net 7 474316 root 1 /run/docker/netns/6698a621349f /pause

*мї®нЕМмЭілДИлКФ лД§нКЄмЫМнБђ лД§мЮДмК§нОШмЭімК§л°Ь лД§нКЄмЫМнБђл•Љ лґДл¶ђнХШкЄ∞ лХМлђЄмЧР 2к∞ЬмЭШ нММлУЬк∞А мДЬл°Ь лЛ§л•Є лД§нКЄмЫМнБђ лД§мЮДмК§нОШмЭімК§(0,1)мЭД к∞АмІАлКФ к≤ГмЭД нЩХмЭЄнХ† мИШ мЮИмКµлЛИлЛ§.

#Pause Containerк∞А лґАл™® нФДл°ЬмДЄмК§мЮЕлЛИлЛ§.

root@sung-ubuntu04:~# ps -ef | grep 313510

root 313510 313479 0 12:35 ? 00:00:00 /pauseмєЉл¶ђмљФ мЭЄнД∞нОШмЭімК§ dumpл•Љ нЖµнХі мЛ§м†Ь нКЄлЮШнФљмЭі мЭілПЩнХШлКФ к≤ГмЭД нЩХмЭЄнХі л≥ік≤†мКµлЛИлЛ§.

#4л≤И лЕЄлУЬмЧРмДЬ cali мЭЄнД∞нОШмЭімК§ нЩХмЭЄ

root@sung-ubuntu04:~# ifconfig -a

calia85a668c715: flags=4163<UP,BROADCAST,RUNNING,MULTICAST> mtu 1480

inet6 fe80::ecee:eeff:feee:eeee prefixlen 64 scopeid 0x20<link>

ether ee:ee:ee:ee:ee:ee txqueuelen 0 (Ethernet)

RX packets 0 bytes 0 (0.0 B)

RX errors 0 dropped 0 overruns 0 frame 0

TX packets 5 bytes 446 (446.0 B)

TX errors 0 dropped 0 overruns 0 carrier 0 collisions 0

calie3df4d89b13: flags=4163<UP,BROADCAST,RUNNING,MULTICAST> mtu 1480

inet6 fe80::ecee:eeff:feee:eeee prefixlen 64 scopeid 0x20<link>

ether ee:ee:ee:ee:ee:ee txqueuelen 0 (Ethernet)

RX packets 3747 bytes 254298 (254.2 KB)

RX errors 0 dropped 0 overruns 0 frame 0

TX packets 5769 bytes 24076756 (24.0 MB)

#calia85a668c715 мЭЄнД∞нОШмЭімК§ tcpdump нЩХмЭЄ

root@sung-ubuntu04:~# VETH1=calia85a668c715

root@sung-ubuntu04:~# tcpdump -i $VETH1 -nn

tcpdump: verbose output suppressed, use -v or -vv for full protocol decode

listening on calia85a668c715, link-type EN10MB (Ethernet), capture size 262144 bytes

..лМАкЄ∞м§С

#лІИмК§нД∞ лЕЄлУЬмЧРмДЬ 4л≤И лЕЄлУЬ PODмЧР ping нЕМмК§нКЄ(лЛ§л•Є мДЄмЕШ)

root@sung-ubuntu01:~/tmp# kubectl get pod -o wide

NAME READY STATUS RESTARTS AGE IP NODE NOMINATED NODE READINESS GATES

multi-container 2/2 Running 0 164m 10.233.78.3 sung-ubuntu05 <none> <none>

multi-container2 2/2 Running 0 69m 10.233.99.2 sung-ubuntu04 <none> <none>

ubuntu-test 1/1 Running 0 3h16m 10.233.99.1 sung-ubuntu04 <none> <none>

#ping

root@sung-ubuntu01:~/tmp# ping 10.233.99.2

PING 10.233.99.2 (10.233.99.2) 56(84) bytes of data.

64 bytes from 10.233.99.2: icmp_seq=1 ttl=63 time=1.38 ms

#calia85a668c715 мЭЄнД∞нОШмЭімК§ tcpdump нЩХмЭЄ

root@sung-ubuntu04:~# tcpdump -i $VETH1 -nn

tcpdump: verbose output suppressed, use -v or -vv for full protocol decode

listening on calia85a668c715, link-type EN10MB (Ethernet), capture size 262144 bytes

16:05:46.144509 IP 10.233.95.0 > 10.233.99.2: ICMP echo request, id 2, seq 1, length 64

16:05:46.145001 IP 10.233.99.2 > 10.233.95.0: ICMP echo reply, id 2, seq 1, length 64

#sung-ubuntu01(10.233.95.0) -> sung-ubuntu04(10.233.99.2)л°Ь ICMP echo request нЩХмЭЄ

---

#sung-ubuntu05 лЕЄлУЬмЭШ нММлУЬмЧРмДЬ ping нЕМмК§нКЄ

root@sung-ubuntu01:~/tmp# kubectl exec -it multi-container -c ubuntu -- bash

root@multi-container:/# ping 10.233.99.2

root@sung-ubuntu04:~# tcpdump -i $VETH1 -nn

tcpdump: verbose output suppressed, use -v or -vv for full protocol decode

listening on calia85a668c715, link-type EN10MB (Ethernet), capture size 262144 bytes

16:13:18.856132 IP 10.233.78.3 > 10.233.99.2: ICMP echo request, id 341, seq 1, length 64

16:13:18.856660 IP 10.233.99.2 > 10.233.78.3: ICMP echo reply, id 341, seq 1, length 64

16:13:23.952285 ARP, Request who-has 10.233.99.2 tell 192.168.110.103, length 28

16:13:23.952244 ARP, Request who-has 169.254.1.1 tell 10.233.99.2, length 28

16:13:23.952792 ARP, Reply 169.254.1.1 is-at ee:ee:ee:ee:ee:ee, length 28

16:13:23.952809 ARP, Reply 10.233.99.2 is-at f6:8b:49:61:d0:02, length 28

* 169.254.1.1(link-local address)

169.254.1.1лКФ IP м£ЉмЖМ кіАл¶ђ лМАнЦЙмВђк∞А мШИмХљнХЬ мШИмХљ IP м£ЉмЖМмЭіл©∞ к≥µмЪ© лШРлКФ к∞ЬмЭЄ IPл°Ь нХ†лЛєлРШмІА мХКмКµлЛИлЛ§.

мШИмХљлРЬ IPлКФ мЭЉл∞Шм†БмЬЉл°Ь мЖМнФДнКЄмЫ®мЦі, к∞ЬмЭЄ лД§нКЄмЫМнБђ, нШЄмК§нКЄ, мДЬлЄМлДЈ, лђЄмДЬ, л≥АнЩШ, л©АнЛ∞ мЇРмК§нКЄ, лЄМл°ЬлУЬ мЇРмК§нКЄ, л°Ьмїђ нЖµмЛ†, л£®нФДл∞±, л¶іл†ИмЭі, лІБнБђ, лІ§нХС, нЕМмК§нКЄ л∞П нЦ•нЫД мВђмЪ©к≥Љ к∞ЩмЭА нКємИШ л™©м†БмЬЉл°Ь мВђмЪ©лР©лЛИлЛ§.

мґЬм≤Ш - https://ko.ipshu.com/ipv4/169.254.1.1

мњ†л≤ДлД§нЛ∞мК§мЧРмДЬ мВђмЪ©нХШлКФ мєЉл¶ђмљФ Poolк≥Љ нХілЛє PoolмЭі мЦілЦ§ л™®лУЬл•Љ мВђмЪ©нХШлКФмІАлПД нЩХмЭЄ нХ† мИШ мЮИмКµлЛИлЛ§.

кµђмґХ нЫД л™®лУЬ л≥Ак≤љмЭі к∞АлК•нХШл©∞, calico нЩИнОШмЭімІАмЧРмДЬ мЮРмДЄнХЬ л∞©л≤ХмЭД нЩХмЭЄ нХ† мИШ мЮИмКµлЛИлЛ§.

#Calico NAT м†Хм±Е нЩХмЭЄ (true)

root@sung-ubuntu01:~/tmp# calicoctl get ippool -o wide

NAME CIDR NAT IPIPMODE VXLANMODE DISABLED DISABLEBGPEXPORT SELECTOR

default-pool 10.233.64.0/18 true Always Never false false all()

#мЫМмї§ лЕЄлУЬмЧРмДЬ iptables nat нЩХмЭЄ

root@sung-ubuntu04:~# iptables -n -t nat --list cali-nat-outgoing

Chain cali-nat-outgoing (1 references)

target prot opt source destination

MASQUERADE all -- 0.0.0.0/0 0.0.0.0/0 /* cali:flqWnvo8yq4ULQLa */ match-set cali40masq-ipam-pools src ! match-set cali40all-ipam-pools dst random-fully

=> cali-nat-outgoing м†Хм±ЕмЬЉл°Ь мЩЄлґАл°Ь лВШк∞АлКФ нМ®нВЈмЭА л™®лСР MASQUERADEнХШмЧђ м≤Шл¶ђлР® (=мЩЄлґАл°Ь лВШк∞АлКФ нКЄлЮШнФљмЭА MASQURADE м†Хм±ЕмЭД нЖµнХі лВШк∞И мИШ мЮИмЭМ)

*IP Masquerade

- NAT кЄ∞мИ† мХИмЧР мЖНнХЬ кЄ∞мИ†л°Ь к∞Ал©імЭілЭЉлКФ мЭШлѓЄ

- NATмЩА лЛ§л•ік≤М м£ЉмЖМл≥АнЩШлІМ нХШлКФ к≤ГмЭі мХДлЛМ нПђнКЄл≤ИнШЄкєМмІА нПђнКЄнПђмЫМлФ© мЛЬмЉЬм£ЉлКФ кЄ∞лК•мЭД к∞АмІАк≥† мЮИмЭМ

- SNAT(Source NAT)мЩА к∞ЩлЛ§к≥† нХ®.

мєЉл¶ђмљФ лД§нКЄмЫМнБђ л∞©мЛЭмЭА Overlay л∞©мЛЭк≥Љ Overlayл•Љ мВђмЪ©нХШмІА мХКлКФ л∞©мЛЭ(Direct)л°Ь кµђлґД нХ† мИШ мЮИмЬЉл©∞, мњ†л≤ДлД§нЛ∞мК§ л∞∞нПђ нИімЭЄ kubespray release-2.19 лґАнД∞ кЄ∞л≥Є мШµмЕШмЭі ipipмЧРмДЬ vxlanмЬЉл°Ь л≥Ак≤љлРШмЧИмКµлЛИлЛ§.

1. Direct л∞©мЛЭ

- Pod нЖµмЛ† нМ®нВЈмЭі мґЬл∞ЬмІА лЭЉмЪ∞нМЕ м†Хл≥іл•Љ л≥ік≥† л™©м†БмІА лЕЄлУЬл°Ь мЫРл≥Є нМ®нВЈ кЈЄлМАл°Ь м†ДлЛђ

- мД±лК•м†БмЬЉл°Ь к∞АмЮ• мЪ∞мИШ

2. Overlay л∞©мЛЭ (нД∞лДРлІБ)

- PodмЭШ лД§нКЄмЫМнБђ м†Хл≥іл•Љ лЕЄлУЬмЧРмДЬ Encapsulation(мЇ°мКРнЩФ)нХШмЧђ л™©м†БмІА лЕЄлУЬл°Ь м†ДлЛђ

- IP кЄ∞л∞ШмЭШ нД∞лДРлІБ л∞©мЛЭмЬЉл°Ь нММлУЬмЭШ нМ®нВЈ м†ДлЛђ

- к∞Б лЕЄлУЬ нМ®нВЈмЧР лМАнХЬ Encapsulation / Decapsulation к≥Љм†Х мЛ§нЦЙ

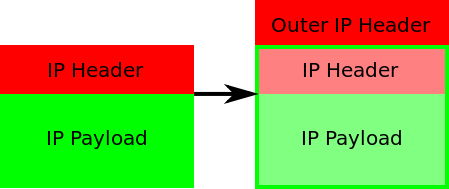

2.1. IPIP л™®лУЬ

вЖТ IP-in-IPлЭЉк≥† лґИл¶ђмЪ∞лКФ Overlay л∞©мЛЭмЬЉл°Ь, CalicoмЭШ кЄ∞л≥Є л™®лУЬ

вЖТ PodмЭШ лД§нКЄмЫМнБђ нМ®нВЈмЭШ кЄ∞м°і IPнЧ§лНФ мХЮмЧР IPнЧ§лНФл•Љ нХШлВШ лНФ лНІлґЩмЧђ нЖµмЛ†нХШлКФ л∞©мЛЭ

вЖТ лЛ§л•Є лЕЄлУЬк∞Д Pod нЖµмЛ†мЭА tunl0 мЭЄнД∞нОШмЭімК§л•Љ нЖµнХі IP нЧ§лНФмЧР к∞РмЛЄм†ЄмДЬ мГБлМА лЕЄлУЬл°Ь лПДлЛђ нЫД tunl0 мЭЄнД∞нОШмЭімК§мЧРмДЬ Outer нЧ§лНФл•Љ м†Ьк±∞нХШк≥† лВілґАмЭШ нММлУЬмЩА нЖµмЛ†

2.2 VXLAN л™®лУЬ

вЖТ PODк∞Д нЖµмЛ†мЭі лЕЄлУЬ кµђк∞ДмЧР VXLAN EncapsultationмЭД нЖµнХі мЭіл£®мЦі мІР

Q. лЕЄлУЬмЭШ мєЉл¶ђмљФ мЭЄнД∞нОШмЭімК§мЭШ mtuлКФ л™ЗмЬЉл°Ь мД§м†ХлРШмЦі мЮИлВШмЪФ?

Calico л™®лУИк≥Љ кЈЄ кЄ∞лК•лУ§мЧР лМАнХімДЬ м†Хл¶ђнХі л≥ік≤†мКµлЛИлЛ§.

мХДлЮШ нСЬлКФ calico нЩИнОШмЭімІАмЧР м†Хл¶ђлРЬ лВімЪ©мЭД мЭЉлґА л≤ИмЧ≠/м†Хл¶ђнХШмШАмКµлЛИлЛ§.

рЯТ° Calico кµђмД±мЪФмЖМ

- The `calico/node` container is deployed to every node (on Kubernetes, by a DaemonSet), and runs three internal daemons:

Felix(нХДл¶≠мК§)

- the Calico daemon that runs on every node and provides endpoints.

- calico-node нММлУЬ мХИмЧР мЬДмєШнХШл©∞, л™®лУ† лЕЄлУЬмЭШ endpoint м†Ьк≥µ

- K8s ETCD м†Хл≥іл•Љ мЭљмЭМ

- лЭЉмЪ∞нМЕ нЕМмЭілЄФ мГЭмД±

- kube-proxyк∞А iptables л™®лУЬмЭЄ к≤љмЪ∞, iptables мї®нКЄл°§

- kube-proxyк∞А ipvs л™®лУЬмЭЄ к≤љмЪ∞, ipvs мї®нКЄл°§ |

BIRD(л≤ДлУЬ)

- the BGP daemon that distributes routing information to other nodes.

- лЛ§л•Є лЕЄлУЬмЧР мЮИлКФ BGP лН∞л™ђлУ§к≥Љ лЭЉмЪ∞нМЕ м†Хл≥і кµРнЩШ.

- TCP 179л•Љ мЭімЪ©нХімДЬ mesh нШХнГЬл°Ь мЧ∞

confd

- a daemon that watches the Calico datastore for config changes and updates

BIRDвАЩs config files.

- Calico лН∞мЭінД∞ м†АмЮ•мЖМмЭШ кµђмД± л≥Ак≤љмЭД к∞РмЛЬнХШк≥† BIRDмЭШ кµђмД± нММмЭЉмЭД мЧЕлН∞мЭінКЄнХШлКФ лН∞л™ђ

мґЬм≤Ш - [https://projectcalico.docs.tigera.io/reference/node/configuration]мЛ§м†Ьл°Ь мєЉл¶ђмљФлКФ мњ†л≤ДлД§нЛ∞мК§мЧРмДЬ мЦілЦїк≤М л∞∞нПђлРШмЦі мВђмЪ©лРШк≥† мЮИмЭДкєМмЪФ?

#calino-nodeлКФ daemonsetмЬЉл°Ь л∞∞нПђлРШмЦімЮИмКµлЛИлЛ§.

root@sung-ubuntu01:/var/lib/cni# kubectl -n kube-system get all | grep cali

pod/calico-kube-controllers-6bc8445c8-kptbp 1/1 Running 48 2d23h

pod/calico-node-ckvhb 1/1 Running 4 (2d23h ago) 2d23h

pod/calico-node-d2pr7 1/1 Running 5 (2d23h ago) 2d23h

pod/calico-node-fnmg9 1/1 Running 5 (2d23h ago) 2d23h

pod/calico-node-gqr27 1/1 Running 9 (2d23h ago) 2d23h

pod/calico-node-gzrt9 1/1 Running 8 (2d23h ago) 2d23h

daemonset.apps/calico-node 5 5 5 5 5 kubernetes.io/os=linux 2d23h

deployment.apps/calico-kube-controllers 1/1 1 1 2d23h

replicaset.apps/calico-kube-controllers-6bc8445c8 1 1 1 2d23h

calico-node нММлУЬл•Љ мВінОіл≥ік≤†мКµлЛИлЛ§. мЦілЦ§ мї®нЕМмЭілДИлУ§л°Ь кµђмД±лРШмЦі мЮИлКФмІА, ProbeлКФ мЦілЦїк≤М м≤інБђнХШлКФмІА, кЄ∞л≥Є л¶ђмЖМмК§лКФ мЦілЦїк≤М мД§м†ХлРШмЦі мЮИлКФмІА нЩХмЭЄнХіл≥імДЄмЪФ. мЛЬмК§нЕЬмЧР кЈЬл™®/мВђмЪ©лЯЙмЧР лФ∞лЭЉмДЬ л¶ђмЖМмК§л•Љ мИШм†ХнХімХЉнХШлКФ к≤љмЪ∞к∞А мЮИмКµлЛИлЛ§.

root@sung-ubuntu01:~# kubectl -n kube-system describe pod calico-node-ckvhb

Name: calico-node-ckvhb

Namespace: kube-system

Priority: 2000001000

Priority Class Name: system-node-critical

Node: sung-ubuntu01/192.168.110.100

Start Time: Fri, 26 Aug 2022 11:33:59 +0900

Labels: controller-revision-hash=bc4df5999

k8s-app=calico-node

pod-template-generation=1

Annotations: <none>

Status: Running

IP: 192.168.110.100

IPs:

IP: 192.168.110.100

Controlled By: DaemonSet/calico-node

Init Containers:

upgrade-ipam:

Container ID: docker://5c0d79f72455a568d8df8242131c7c997200ad6a0612819e76ed731a599f5d18

Image: quay.io/calico/cni:v3.21.2

Image ID: docker-pullable://quay.io/calico/cni@sha256:7aa6c97fc5f6a6959f8b06bacc12e6f593c68e6e0839e1f454ba0b9523255a79

Port: <none>

Host Port: <none>

Command:

/opt/cni/bin/calico-ipam

-upgrade

State: Terminated

Reason: Completed

Exit Code: 0

Started: Fri, 26 Aug 2022 11:34:42 +0900

Finished: Fri, 26 Aug 2022 11:34:42 +0900

Ready: True

Restart Count: 0

Environment Variables from:

kubernetes-services-endpoint ConfigMap Optional: true

Environment:

KUBERNETES_NODE_NAME: (v1:spec.nodeName)

CALICO_NETWORKING_BACKEND: <set to the key 'calico_backend' of config map 'calico-config'> Optional: false

Mounts:

/host/opt/cni/bin from cni-bin-dir (rw)

/var/lib/cni/networks from host-local-net-dir (rw)

/var/run/secrets/kubernetes.io/serviceaccount from kube-api-access-bhp9z (ro)

install-cni:

Container ID: docker://deaf5d827119ae09e88b6f2dd816e4e7d7b04b5bbe39c67daaf70b268af3f2cd

Image: quay.io/calico/cni:v3.21.2

Image ID: docker-pullable://quay.io/calico/cni@sha256:7aa6c97fc5f6a6959f8b06bacc12e6f593c68e6e0839e1f454ba0b9523255a79

Port: <none>

Host Port: <none>

Command:

/opt/cni/bin/install

State: Terminated

Reason: Completed

Exit Code: 0

Started: Fri, 26 Aug 2022 11:35:33 +0900

Finished: Fri, 26 Aug 2022 11:36:19 +0900

Ready: True

Restart Count: 0

Environment Variables from:

kubernetes-services-endpoint ConfigMap Optional: true

Environment:

CNI_CONF_NAME: 10-calico.conflist

UPDATE_CNI_BINARIES: true

CNI_NETWORK_CONFIG_FILE: /host/etc/cni/net.d/calico.conflist.template

SLEEP: false

KUBERNETES_NODE_NAME: (v1:spec.nodeName)

Mounts:

/host/etc/cni/net.d from cni-net-dir (rw)

/host/opt/cni/bin from cni-bin-dir (rw)

/var/run/secrets/kubernetes.io/serviceaccount from kube-api-access-bhp9z (ro)

flexvol-driver:

Container ID: docker://af898ab3c87a361deb668e39cccbcbaa8e8b7cc2bc3779bffcddb25d8b298d23

Image: quay.io/calico/pod2daemon-flexvol:v3.21.2

Image ID: docker-pullable://quay.io/calico/pod2daemon-flexvol@sha256:2397cea01382233f942edeecc2c205e241aa0a292e2624449df9b6c9381fa1a5

Port: <none>

Host Port: <none>

State: Terminated

Reason: Completed

Exit Code: 0

Started: Fri, 26 Aug 2022 11:36:45 +0900

Finished: Fri, 26 Aug 2022 11:36:45 +0900

Ready: True

Restart Count: 0

Environment: <none>

Mounts:

/host/driver from flexvol-driver-host (rw)

/var/run/secrets/kubernetes.io/serviceaccount from kube-api-access-bhp9z (ro)

Containers:

calico-node:

Container ID: docker://8f6b34864db9b809b59a8da7e9149979d91bdac10c5477edcd70ebbf593e14d0

Image: quay.io/calico/node:v3.21.2

Image ID: docker-pullable://quay.io/calico/node@sha256:895a10b9d68d8f724f72e0bd002d435862ce997c85658ce7d4c6407c34bc65ab

Port: <none>

Host Port: <none>

State: Running

Started: Fri, 26 Aug 2022 11:40:30 +0900

Last State: Terminated

Reason: Error

Exit Code: 1

Started: Fri, 26 Aug 2022 11:39:13 +0900

Finished: Fri, 26 Aug 2022 11:39:31 +0900

Ready: True

Restart Count: 4

Limits:

cpu: 300m

memory: 500M

Requests:

cpu: 150m

memory: 64M

Liveness: exec [/bin/calico-node -felix-live -bird-live] delay=10s timeout=10s period=10s #success=1 #failure=6

Readiness: exec [/bin/calico-node -bird-ready -felix-ready] delay=0s timeout=10s period=10s #success=1 #failure=6

Environment Variables from:

kubernetes-services-endpoint ConfigMap Optional: true

Environment:

DATASTORE_TYPE: kubernetes

WAIT_FOR_DATASTORE: true

CALICO_NETWORKING_BACKEND: <set to the key 'calico_backend' of config map 'calico-config'> Optional: false

CLUSTER_TYPE: <set to the key 'cluster_type' of config map 'calico-config'> Optional: false

CALICO_K8S_NODE_REF: (v1:spec.nodeName)

CALICO_DISABLE_FILE_LOGGING: true

FELIX_DEFAULTENDPOINTTOHOSTACTION: RETURN

FELIX_HEALTHHOST: localhost

FELIX_IPTABLESBACKEND: Legacy

FELIX_IPTABLESLOCKTIMEOUTSECS: 10

CALICO_IPV4POOL_IPIP: Off

FELIX_IPV6SUPPORT: False

FELIX_LOGSEVERITYSCREEN: info

CALICO_STARTUP_LOGLEVEL: error

FELIX_USAGEREPORTINGENABLED: False

FELIX_CHAININSERTMODE: Insert

FELIX_PROMETHEUSMETRICSENABLED: False

FELIX_PROMETHEUSMETRICSPORT: 9091

FELIX_PROMETHEUSGOMETRICSENABLED: True

FELIX_PROMETHEUSPROCESSMETRICSENABLED: True

NODEIP: (v1:status.hostIP)

IP_AUTODETECTION_METHOD: can-reach=$(NODEIP)

IP: autodetect

NODENAME: (v1:spec.nodeName)

FELIX_HEALTHENABLED: true

FELIX_IGNORELOOSERPF: False

CALICO_MANAGE_CNI: true

Mounts:

/host/etc/cni/net.d from cni-net-dir (rw)

/lib/modules from lib-modules (ro)

/run/xtables.lock from xtables-lock (rw)

/var/lib/calico from var-lib-calico (rw)

/var/log/calico/cni from cni-log-dir (ro)

/var/run/calico from var-run-calico (rw)

/var/run/nodeagent from policysync (rw)

/var/run/secrets/kubernetes.io/serviceaccount from kube-api-access-bhp9z (ro)

Conditions:

Type Status

Initialized True

Ready True

ContainersReady True

PodScheduled True

Volumes:

lib-modules:

Type: HostPath (bare host directory volume)

Path: /lib/modules

HostPathType:

var-run-calico:

Type: HostPath (bare host directory volume)

Path: /var/run/calico

HostPathType:

var-lib-calico:

Type: HostPath (bare host directory volume)

Path: /var/lib/calico

HostPathType:

cni-net-dir:

Type: HostPath (bare host directory volume)

Path: /etc/cni/net.d

HostPathType:

cni-bin-dir:

Type: HostPath (bare host directory volume)

Path: /opt/cni/bin

HostPathType:

xtables-lock:

Type: HostPath (bare host directory volume)

Path: /run/xtables.lock

HostPathType: FileOrCreate

host-local-net-dir:

Type: HostPath (bare host directory volume)

Path: /var/lib/cni/networks

HostPathType:

cni-log-dir:

Type: HostPath (bare host directory volume)

Path: /var/log/calico/cni

HostPathType:

policysync:

Type: HostPath (bare host directory volume)

Path: /var/run/nodeagent

HostPathType: DirectoryOrCreate

flexvol-driver-host:

Type: HostPath (bare host directory volume)

Path: /usr/libexec/kubernetes/kubelet-plugins/volume/exec/nodeagent~uds

HostPathType: DirectoryOrCreate

kube-api-access-bhp9z:

Type: Projected (a volume that contains injected data from multiple sources)

TokenExpirationSeconds: 3607

ConfigMapName: kube-root-ca.crt

ConfigMapOptional: <nil>

DownwardAPI: true

QoS Class: Burstable

Node-Selectors: kubernetes.io/os=linux

Tolerations: op=Exists

node.kubernetes.io/disk-pressure:NoSchedule op=Exists

node.kubernetes.io/memory-pressure:NoSchedule op=Exists

node.kubernetes.io/network-unavailable:NoSchedule op=Exists

node.kubernetes.io/not-ready:NoExecute op=Exists

node.kubernetes.io/pid-pressure:NoSchedule op=Exists

node.kubernetes.io/unreachable:NoExecute op=Exists

node.kubernetes.io/unschedulable:NoSchedule op=Exists

Events: <none>мЬД calico-node мД§м†ХмЧРмДЬ мД§м†Х нММмЭЉмЭД м∞ЊмЬЉмЕ®лВШмЪФ? нХілЛє нММмЭЉмЭД м∞ЊмХДл≥іл©і мЛ§м†Ьл°Ь мєЉл¶ђмљФмЭШ мД§м†ХмЭД нЩХмЭЄ нХ† мИШ мЮИмКµлЛИлЛ§.

root@sung-ubuntu01:/etc/cni/net.d# ll

total 20

drwxr-xr-x 2 kube root 4096 Aug 26 11:36 ./

drwxr-xr-x 3 kube root 4096 Aug 26 11:08 ../

-rw-r--r-- 1 root root 713 Aug 26 11:36 10-calico.conflist

-rw------- 1 root root 2850 Aug 29 11:59 calico-kubeconfig

-rw-r--r-- 1 root root 715 Aug 26 11:32 calico.conflist.template

root@sung-ubuntu01:/etc/cni/net.d# cat 10-calico.conflist

{

"name": "cni0",

"cniVersion":"0.3.1",

"plugins":[

{

"datastore_type": "kubernetes",

"nodename": "sung-ubuntu01",

"type": "calico",

"log_level": "info",

"log_file_path": "/var/log/calico/cni/cni.log",

"ipam": {

"type": "calico-ipam",

"assign_ipv4": "true",

"ipv4_pools": ["10.233.64.0/18"]

},

"policy": {

"type": "k8s"

},

"kubernetes": {

"kubeconfig": "/etc/cni/net.d/calico-kubeconfig"

}

},

{

"type":"portmap",

"capabilities": {

"portMappings": true

}

},

{

"type":"bandwidth",

"capabilities": {

"bandwidth": true

}

}

]

}

мєЉл¶ђмљФ мЭЄнД∞нОШмЭімК§ мД§л™Е лґАлґДмЧРмДЬ 169.254.1.1 мХДмЭінФЉк∞А кЄ∞мЦµлВШмЛЬлВШмЪФ? нХілЛє мХДмЭінФЉл•Љ нКємИШ л™©м†БмЬЉл°Ь мВђмЪ©нХШлКФ мШИмХљ IP м£ЉмЖМлЭЉк≥† мД§л™ЕмЭД нЦИмКµлЛИлЛ§. нХілЛє мХДмЭінФЉл•Љ link-local addressлЭЉк≥† нХШл©∞, мњ†л≤ДлД§нЛ∞мК§ лЕЄлУЬ мЭЄнД∞нОШмЭімК§мЩА нММлУЬ мХИмЭШ мЭЄнД∞нОШмЭімК§л•Љ мЭімЦім£ЉлКФ мЧ≠нХ†мЭД нХ©лЛИлЛ§.

###

#sung-ubuntu05 лЕЄлУЬмЭШ нММлУЬмЧРмДЬ ping нЕМмК§нКЄ

root@sung-ubuntu01:~/tmp# kubectl exec -it multi-container -c ubuntu -- bash

root@multi-container:/# ping 10.233.99.2

root@sung-ubuntu04:~# tcpdump -i $VETH1 -nn

tcpdump: verbose output suppressed, use -v or -vv for full protocol decode

listening on calia85a668c715, link-type EN10MB (Ethernet), capture size 262144 bytes

16:13:18.856132 IP 10.233.78.3 > 10.233.99.2: ICMP echo request, id 341, seq 1, length 64

16:13:18.856660 IP 10.233.99.2 > 10.233.78.3: ICMP echo reply, id 341, seq 1, length 64

16:13:23.952285 ARP, Request who-has 10.233.99.2 tell 192.168.110.103, length 28

16:13:23.952244 ARP, Request who-has 169.254.1.1 tell 10.233.99.2, length 28

16:13:23.952792 ARP, Reply 169.254.1.1 is-at ee:ee:ee:ee:ee:ee, length 28

16:13:23.952809 ARP, Reply 10.233.99.2 is-at f6:8b:49:61:d0:02, length 28

###

TCP dump мГБмЧРмДЬ л≥імШАлНШ лВѓмД† IP 169.254.1.1лКФ мШИмХљ IP м£ЉмЖМмЭіл©∞, link-local addressрЯТ° link-local address

- мІБм†С мЧ∞к≤∞лРЬ лПЩмЭЉ лІБнБђ л∞П subnetмЧРмДЬ мВђмЪ©нХШлКФ м£ЉмЖМ

- лІБнБђ л°Ьмїђ м£ЉмЖМлКФ FE80::/10мЭШ к≥†м†ХлРЬ лМАмЧ≠к≥Љ interfaceмЭШ EUI-64 IDмЭШ к≤∞нХ©мЬЉл°Ь мЭіл£®мЦімІР

- 169.254.1.0 ~ 169.254.254.255(IPv4) л≤ФмЬДмЭШ мШИмХљлРЬ лД§нКЄмЫМнБђ м£ЉмЖМ

лЛ§мЛЬ лЕЄлУЬмЭШ лД§нКЄмЫМнБђ мЭЄнД∞нОШмЭімК§л•Љ нЩХмЭЄнХі л≥ік≤†мКµлЛИлЛ§. лЕЄлУЬ мЭЄнД∞нОШмЭімК§к∞А нММлУЬ мЭЄнД∞нОШмЭімК§мЩА мЦілЦїк≤М мЧ∞к≤∞мЭі лРШмЦімЮИлКФмІА dumpлВімЪ©к≥Љ лєДкµРнХіл≥імДЄмЪФ.

root@sung-ubuntu04:~# ifconfig

calia85a668c715: flags=4163<UP,BROADCAST,RUNNING,MULTICAST> mtu 1480

inet6 fe80::ecee:eeff:feee:eeee prefixlen 64 scopeid 0x20<link>

ether ee:ee:ee:ee:ee:ee txqueuelen 0 (Ethernet)

RX packets 75 bytes 6790 (6.7 KB)

RX errors 0 dropped 0 overruns 0 frame 0

TX packets 80 bytes 7236 (7.2 KB)

TX errors 0 dropped 0 overruns 0 carrier 0 collisions 0

calie3df4d89b13: flags=4163<UP,BROADCAST,RUNNING,MULTICAST> mtu 1480

inet6 fe80::ecee:eeff:feee:eeee prefixlen 64 scopeid 0x20<link>

ether ee:ee:ee:ee:ee:ee txqueuelen 0 (Ethernet)

RX packets 3747 bytes 254298 (254.2 KB)

RX errors 0 dropped 0 overruns 0 frame 0

TX packets 5769 bytes 24076756 (24.0 MB)

TX errors 0 dropped 0 overruns 0 carrier 0 collisions 0

...

#ubuntu мї®нЕМмЭілДИ м†СмЖН

root@sung-ubuntu01:~/tmp# kubectl exec -it multi-container -c ubuntu -- bash

root@multi-container:/# apt install iproute2 -y

root@multi-container:/# ip route

default via 169.254.1.1 dev eth0

169.254.1.1 dev eth0 scope link

=> 169.254.1.1лКФ нММлУЬмЭШ IPv4 link-local Address

лІИмІАлІЙмЬЉл°Ь к≥µмЛЭ нЩИнОШмЭімІАмЧРмДЬ мД§л™ЕнХШлКФ мєЉл¶ђмљФ лН∞мЭінД∞нЭРл¶ДмЭД нЩХмЭЄнХіл≥імДЄмЪФ.

кЄЄк≤М мД§л™ЕнХЬ лВімЪ©мЭі нХЬ нОШмЭімІАмЧР м†Хл¶ђк∞А лРШмЦімЮИмЬЉл©∞, л™®лУ† к≤ГмЭі мєЉл¶ђмљФмЧРмДЬ мЮРлПЩмЬЉл°Ь мЭіл£®мЦімІАкЄ∞ лХМлђЄмЧР нЭРл¶ДлІМ мЭµнЮИл©і лђЄм†Ьк∞А мГЭк≤ЉмЭД к≤љмЪ∞ нХік≤∞мЭі мИШмЫФ нХ† к≤ГмЮЕлЛИлЛ§!

https://projectcalico.docs.tigera.io/reference/architecture/data-path